Als je al langer met SEO en content werkt, weet je dat Google een beetje een black box is. Dat is soms frustrerend, maar het is óók een reden dat zoeken bruikbaar blijft. In een nieuwe affidavit van Elizabeth Reid, vice president en hoofd van Search bij Google, waarschuwt ze een federale rechtbank dat gedwongen datadeling met concurrenten volgens haar leidt tot directe en onomkeerbare schade. Niet alleen voor Google zelf, maar ook voor gebruikers en voor het web als geheel.

Ik snap dat dit snel klinkt als een bedrijf dat zijn positie verdedigt. Tegelijkertijd is het goed om als ondernemer of marketeer in Nederland te begrijpen wát er precies op tafel ligt. Want als de spelregels rond indexen, rankings en het hergebruik van zoekresultaten veranderen, voel je dat uiteindelijk in je organische verkeer, je contentkosten en de betrouwbaarheid van zoekresultaten.

Waar deze zaak over gaat, zonder ruis

Reid diende haar verklaring in om een deel van de antitrustmaatregelen tijdelijk te pauzeren terwijl Google in beroep gaat in de zaak van het Amerikaanse ministerie van Justitie. In de kern draait het om een rechterlijk vonnis dat Google zou verplichten om drie soorten ‘kroonjuwelen’ te delen met zogenoemde ‘gekwalificeerde concurrenten’.

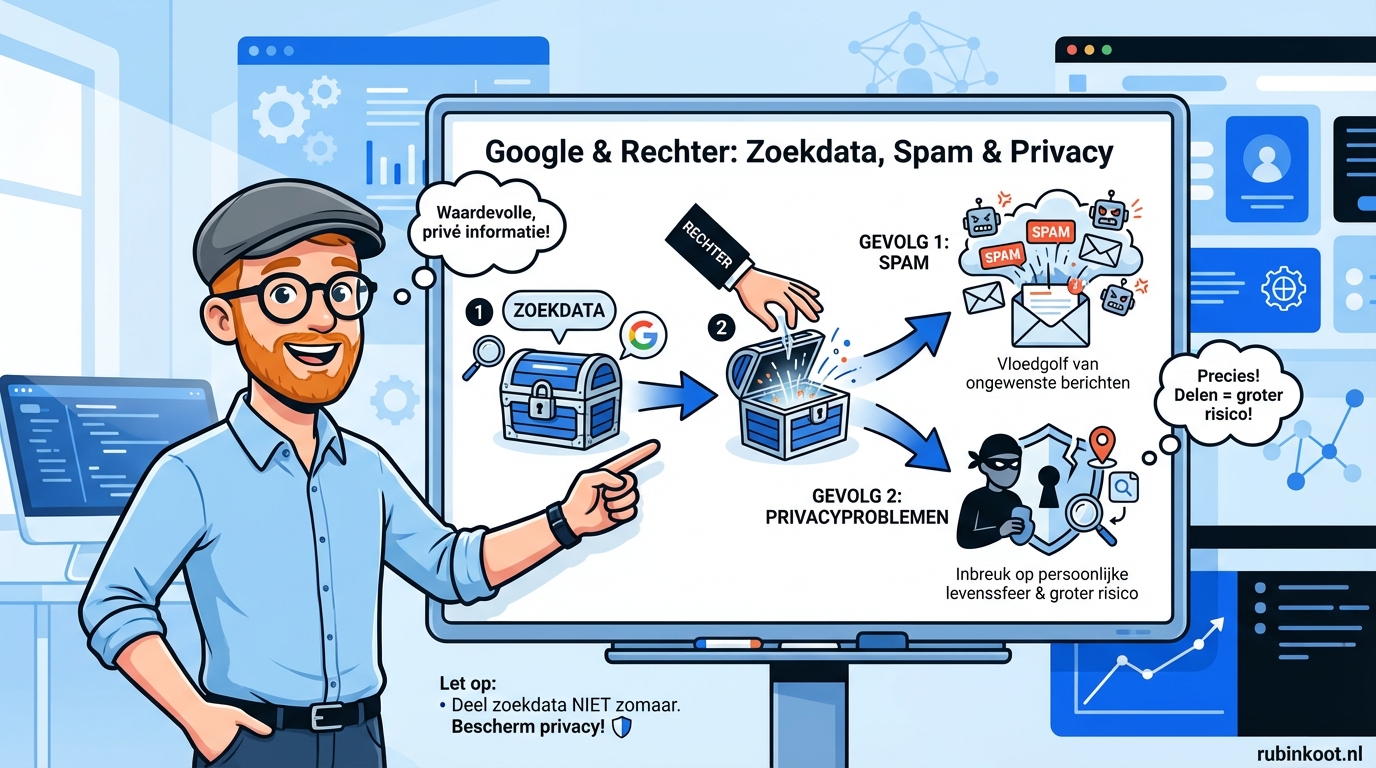

Het gaat niet om een paar rapporten of wat geanonimiseerde trends, maar om de basis van hoe zoeken werkt. Denk aan de webindex zelf, data die gebruikt wordt om rankingmodellen te trainen, en zelfs live zoekresultaten en features die normaal alleen op Google te zien zijn. Google stelt dat dit concurrenten in staat stelt om hun systemen te kopiëren, spam te versnellen en gebruikersdata in omloop te brengen op een manier die zij niet meer kan controleren.

Het delen van de webindex: een eenmalige dump met grote gevolgen

Een van de voorgestelde maatregelen, in het vonnis aangeduid als Section IV, zou betekenen dat Google zijn kern webindex eenmalig moet overdragen tegen marginale kosten. Het gaat dan om elke URL die in de index staat, een koppeling tussen interne document ID’s en URL’s, gegevens over wanneer en hoe vaak er gecrawld wordt, spam scores en zelfs flags die aangeven voor welk type apparaat iets relevant is.

Volgens Reid is die selectie van wat wel en niet in de index komt geen simpele optelsom, maar het resultaat van meer dan vijfentwintig jaar aan investeringen in crawling, annotatie en een gelaagde indexstructuur. Met andere woorden, je geeft niet alleen data weg, je geeft ook de uitkomst van een hele reeks keuzes en systemen weg.

Haar kernpunt is praktisch. Als een concurrent exact weet welke pagina’s wél in de index zitten, kan die een groot deel van het web overslaan. Dan hoeft zo’n partij niet meer breed te crawlen om te ontdekken wat de moeite waard is, maar kan ze zich richten op het deel dat al door Google is ‘voor gefilterd’. Dat verkort jaren werk tot een kopieeractie met een voorsprong.

Waarom crawlgegevens meer verraden dan je denkt

Veel mensen denken bij een index aan een lijst met pagina’s. De extra metadata is waar het spannend wordt. In de verklaring wordt specifiek genoemd dat informatie over het crawlschema inzicht geeft in signalen rond versheid en vraag. Als je weet welke pagina’s vaak opnieuw bezocht worden, en welke minder, zie je iets van de prioriteiten en de interne ‘tiers’ in de index.

Dat klinkt abstract, maar het komt neer op dit. Je krijgt een kijkje in hoe het systeem bepaalt wat snel moet worden bijgewerkt, wat vermoedelijk veel gebruikers raakt, en wat achteraan in de rij mag staan. Voor partijen die zoeken willen nabouwen of manipuleren, is dat precies het soort aanwijzing dat je normaal nooit zou prijsgeven.

In dezelfde context verwijst Reid naar een visual over het crawl en indexproces waarin een groot deel van het web wordt gelabeld als spam, duplicaat of lage kwaliteit. Ook wordt aangehaald dat Google op een schaal van triljoenen pagina’s heeft gecrawld en dat er in 2020 volgens interne getuigenis grofweg 400 miljard documenten in de index zaten. Dat is de orde van grootte waar we over praten.

Spam en misbruik: waarom transparantie hier averechts kan werken

Reid legt een punt neer dat ik in de praktijk ook herken. Goede spamdetectie werkt juist omdat niet iedereen precies weet welke signalen je gebruikt. Zodra spammers begrijpen waar de grenzen liggen, gaan ze eromheen werken. Zij noemt het letterlijk. Spam bestrijden leunt op ondoorzichtigheid, omdat externe kennis over mechanismen of signalen de waarde ervan onderuit haalt.

Als spam scores, direct of indirect, uitlekken of via een beveiligingsincident op straat komen te liggen, krijgen kwaadwillenden feedback die ze nu niet hebben. Dan wordt het makkelijker om content net onder de radar te houden. Het gevolg is niet alleen meer rommel in de zoekresultaten, maar ook een veiligheidsprobleem. Denk aan misleiding, nepwebshops, medische onzin of phishing die net iets geloofwaardiger wordt.

En dan komt het menselijke stuk. Gebruikers geven Google de schuld als zoekresultaten slechter worden, ook als die verslechtering komt doordat data verplicht gedeeld is. Vertrouwen is snel weg en moeilijk terug te winnen, zeker als je zoekmachine jouw ‘poort’ naar het web is.

Gebruikersdata voor Glue en RankEmbed: rankinguitkomst op enorme schaal

De tweede categorie is misschien nog gevoeliger, omdat die dichter tegen gedrag en privacy aan zit. Het vonnis zou doorlopende deling eisen van ‘user side data’ die gebruikt wordt voor de modellen Glue en RankEmbed. In de affidavit staat dat het onder meer gaat om zoekopdrachten, locatie, tijdstip, klikken, hovers en andere interacties, plus welke resultaten en zoekfeatures getoond werden en in welke volgorde.

Reid schrijft dat Glue dertien maanden aan Amerikaanse zoeklogs bevat. Haar argument is dat dit in feite neerkomt op het prijsgeven van de rankingoutput van Google op schaal. Je ziet dan namelijk voor een enorme set echte queries wat het systeem teruggeeft. Dat is niet zomaar trainingsdata, het is ook een spiegel van het rankinggedrag.

Daarnaast benoemt ze iets dat veel marketeers inmiddels intuïtief snappen. Als je dit soort datasets hebt, kun je ze niet alleen gebruiken om een zoekmachine te bouwen, maar ook om een groot taalmodel te trainen. Zo’n concurrent kan de data dus dubbel benutten. Eerst om zoekresultaten te reproduceren, daarna om AI systemen te voeden met precies die combinatie van query, context en output waar Google jaren aan heeft gesleuteld.

Privacy: wie beslist straks over anonimiseren, en wie krijgt de schuld

Op papier klinkt het geruststellend als data ‘geanonimiseerd’ wordt gedeeld. In de praktijk zit daar veel grijs gebied. Reid benadrukt dat Google volgens dit voorstel niet de eindbeslissing houdt over de anonimiserings en privacytechnieken die op de gebruikersdata worden toegepast voordat die gedeeld wordt.

Dat is belangrijk, want verantwoordelijkheid en controle lopen dan uit elkaar. Als er later discussie ontstaat over herleidbaarheid, een lek bij een derde partij of onverwacht hergebruik, dan kijken gebruikers niet naar een juridische constructie. Die kijken naar het merk dat ze kennen. Haar verwachting is dan ook dat mensen Google alsnog verantwoordelijk houden voor privacy of beveiligingsproblemen die uit die datadeling voortkomen.

Voor ons als ondernemers is dit een goede reality check. Data delen is niet alleen een technische operatie, het is reputatierisico. Wie met klantdata werkt, herkent dat. Je kunt contractueel veel dichttimmeren, maar vertrouwen is vooral psychologisch en gaat over wie je als eindgebruiker ‘de eigenaar’ van het probleem vindt.

Syndicatie van live zoekresultaten: controleverlies en een nieuwe scrape economie

De derde pijler, Section V, gaat over het verplicht licenseren en syndicen van zoekresultaten en features tot wel vijf jaar. Het gaat dan om de klassieke organische resultaten, maar ook om query rewriting en onderdelen zoals Local, Maps, Images, Video en Knowledge Panels.

Google stelt dat dit de live output van zijn systemen blootlegt. Zelfs als er contracten zijn die bepalen wat een ‘gekwalificeerde concurrent’ wel en niet mag, verliest Google de normale mogelijkheid om te weigeren. Reid benoemt dat expliciet. Het syndicatieruimte wordt dus niet alleen groter, het wordt ook minder selectief.

En dan komt een effect dat vaak onderschat wordt. Als concurrenten die resultaten op hun eigen sites tonen, kunnen derden ze weer scrapen. Reid waarschuwt dat iedereen die toegang heeft tot die concurrerende sites, in feite ook aan de resultaten en features kan komen. Je creëert daarmee een keten waarin de data steeds verder verspreidt, waarbij het steeds lastiger wordt om misbruik, opslag en lekken te voorkomen.

Wat je hier als Nederlandse ondernemer of marketeer mee moet

Je hoeft geen fan te zijn van Google om dit serieus te nemen. Als de toegang tot indexen, rankingoutput en live SERP data breder wordt, verandert het speelveld op drie manieren.

Ten eerste kan de kwaliteit van zoekresultaten onder druk komen te staan als spam sneller leert wat werkt. Dat raakt niet alleen gebruikers, maar ook bedrijven die netjes investeren in content en techniek. Je wilt niet concurreren in een markt waar misleiding makkelijker rendeert.

Ten tweede wordt het landschap voor SEO en content onrustiger. Meer partijen kunnen zoekinterfaces bouwen op basis van dezelfde ‘bron’, waardoor distributie verschuift. Dat kan kansen geven, maar het kan ook betekenen dat je zichtbaarheid meer versnipperd raakt over meerdere plekken.

Ten derde zie je hoe waardevol trainingsdata en outputdata zijn voor AI. Als dit soort datasets in omloop komen, versnelt de ontwikkeling van systemen die ‘zoeken met antwoord’ combineren. Dat vraagt van jou dat je minder leunt op één kanaal en meer bouwt aan merk, herhaalbezoek en eigen data, zoals e mail, community, klantenservice content en retentie. Dat zijn geen sexy adviezen, maar het zijn wel de buffers die je overeind houden als het verkeer een keer tegenzit.

De bron van de waarschuwing, voor wie het wil nalezen

De verklaring waar dit over gaat is de Affidavit of Elizabeth Reid, ingediend op 16 januari om 15:46 ET als Document 1471, Attachment 2, in de zaak United States of America v. Google LLC, No. 1:20 cv 03010 in de District Court for the District of Columbia. Ze is verantwoordelijk voor Google Search en stelt dat de affidavit gebaseerd is op haar persoonlijke kennis.

Mijn advies is simpel. Volg deze ontwikkeling, niet omdat je morgen je hele SEO aanpak moet omgooien, maar omdat dit laat zien hoe belangrijk de onderlaag van zoeken is. Wie die onderlaag in handen krijgt, krijgt invloed op de kwaliteit van het web, en dus ook op jouw bereik.